Содержание

Если вы управляете сервером на Nukkit или Spigot, то наверняка сталкивались с проблемами лагов, просадок TPS или высоким потреблением CPU/памяти. Тут вам поможет плагин Spark — мощный профайлер производительности, который поможет выявить узкие места в вашем сервере. Это не просто инструмент, а полноценная диагностическая система, поддерживаемая сообществом и обновляемая!

Что такое Spark и зачем он нужен?

Spark — это профайлер для Minecraft-серверов, клиентов и прокси. Для Nukkit он добавляет инструменты для:

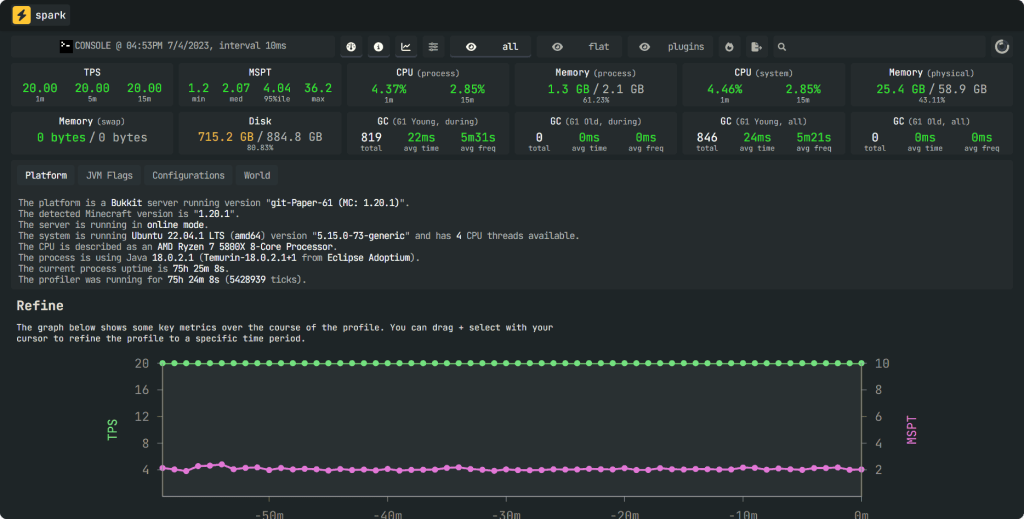

- Диагностики CPU: Выявление «лаговых» плагинов, тиков или потоков, которые жрут ресурсы.

- Анализа памяти: Проверка утечек, хип-дампов и GC (сборки мусора).

- Мониторинга здоровья сервера: Отслеживание TPS, загрузки чанков, активности игроков.

Установка Spark

- Скачайте плагин Spark-Nukkit либо Spark-Spigot

- Установите плагин в папку /plugins

- Запустите сервер

- Проверьте логи: должно появиться «spark has been enabled» без ошибок, или введите команду /pl, /plugins и убедитесь что плагин загружен.

Профилировщик

/spark profiler

Подкоманда profiler используется для управления Spark Profiler.

Если профилировщик уже работает в фоновом режиме, запустите его:

/spark profiler openчтобы открыть страницу просмотра профилировщика без остановки профилировщика./spark profiler stopчтобы остановить профилировщик и просмотреть результаты./spark profiler cancelчтобы отменить профилирование, остановите его, не загружая результаты.

Для базовой работы запустите:

/spark profiler startзапустите профилировщик в режиме работы по умолчанию./spark profiler stopчтобы остановить профилировщик и просмотреть результаты./spark profiler infoчтобы проверить текущий статус профилировщика.

Есть несколько дополнительных флагов, которые можно использовать для настройки поведения профилировщика. Вы можете использовать:

/spark profiler start --timeout <seconds>чтобы запустить профилировщик и автоматически остановить его через x секунд./spark profiler start --thread *чтобы запустить профилировщик и отслеживать все потоки./spark profiler start --allocчтобы запустить профилировщик и проанализировать распределение памяти (нагрузку на память), а не использование процессора.